SEO

GoogleのBERTとは?SEOへの影響の大きさについて

- 最終更新日:

GoogleのBERTは2018年10月にGoogleが発表した機械学習による自然言語処理モデルです。このBERTは2019年からGoogleの検索エンジンに導入されています。

BERTの登場により、Google検索エンジンにおける文脈の理解度が飛躍的に向上し、ユーザーの検索意図に合致した結果が表示されやすくなりました。

よって、現在のSEO対策においては、BERTが何を理解しているのかを知っておくことも重要です。

この記事では、BERTとは何かについて、自然言語処理の観点や経緯から解説をしていきます。

BERTとは?

BERTとは、Bidirectional Encoder Representations from Transformersの略で、日本語に訳すと「Transformerによる双方向のエンコード表現」となります。2018年10月にGoogleのJacob Devlin氏らが「BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding」という論文で発表し、大きな注目を浴びました。

AIの発展に伴い、機械がテキストを理解し、自然言語を処理する能力が飛躍的に向上してきました。BERTはTransformerと呼ばれる新しいアーキテクチャを用いて学習を行います。BERTはそのBidirectional(双方向)な性質により、高い文脈の理解度を誇ります。

BERTとRankBrainの違い

GoogleはBERTの発表よりも前の2015年に、検索エンジンに初めてAIによるアルゴリズムを採用しました。それをRankBrainと呼びます。

BERTはRankBrainの代わりとなったわけではなく、両方とも現在においても用いられており、それぞれに異なる役割を果たしています。

二つとも、曖昧な検索キーワードの理解度を向上させるという点で目的は同じですがアプローチが異なります。

RankBrainは、新たな検索キーワードを見つけ、それと既知の検索キーワードとを関連付けるということをしています。検索キーワードとコンテンツに含まれるキーワードが全く同じでなくとも、それらが同じ意味であるということをGoogleが理解するのを助けています。

例えば「ホームページ制作」と「Web制作」は同じ意味だということを理解しているのはRankBrainの働きが大きいと言えます。

BERTは、文脈の中での前後の関係を双方向に分析しています。より複雑で文脈に依存するような検索キーワードを処理するのに適しています。

自然言語処理とは?

では、自然言語処理とは何かご説明します。例えば、

黒く大きい目の猫

この文章の意味は、以下のどちらともあり得ます。

- 大きな目を持つ黒い猫

- 目が黒く、その目が大きい猫

私たちは、過去の経験、発話のイントネーションや表情、前後の文脈、雰囲気、視覚的情報など様々な情報を元に、脳内で意味の特定を行っています。

この例で言えば、黒い猫は目が黄色いという記憶も踏まえて、「大きな目を持つ黒い猫」という意味だという風に無意識のうちに捉えます。

これを、機械学習で特定しようとするのが自然言語処理です。

自然言語処理の対義語としては、プログラミング言語があります。

プログラミング言語は、JavaScriptの書き方を例として次のようなものがあります(ちょっと書き方が古いかもしれませんが、わかりやすい書き方なのでこれで)。

let a = a + 1;これは、aという変数に1を加えるという意味で、それ以外の意味は持ちません。意味を特定できなければ、プログラミングはエラーを返すようにできています。

Transformerとは?

BERTにはTransformerが用いられていると説明しました。そもそもTransformerとは何か?日本のロボットアニメーションとは別のTransformerです。

ここで言うTransformerは2017年に発表された「Attention Is All You Need」という論文の中で示された深層学習モデルです。

Transformerの特徴は、機械学習のもととするデータを重み付けし、重要なものを見出し、重要度を考慮した結果を出力するところにあります。

これにより、少ないリソースで高い精度を示すことができるようになったのです。

ChatGPTにもTransformerが用いられており、現在の自然言語処理の発展の起点になっているといえるのがTransformerです。

BERTのすごさ

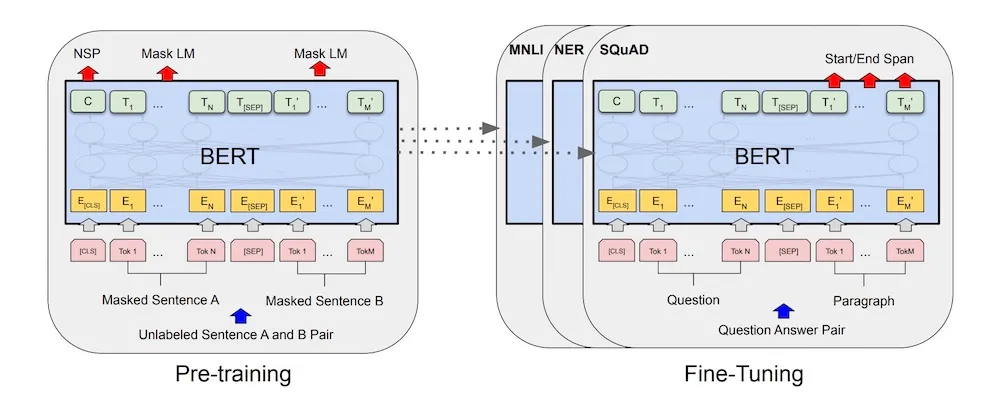

BERTに話を戻します。BERTは上述のTransformerを双方向に用いているところに特徴があります。そのために「Masked Language Model」という仕組みを導入しました。

機械学習は、大量の文章を読み込んで学習していきます。とある文章の中にある問いの解がその後に登場すれば、その解を学習しますが、先に解が出てくると学習ができなくなります。そのため、文章を後ろからも読み込んでいくという処理が効果があり、このことを双方向と呼んでいます。

さらにBERTは、次の段落かどうかを予測するタスクを事前学習しておく「Next Sentence Prediction」によって精度を上げています。

引用:BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

BERT導入前後の違い

Googleによる記事「Google検索を支えるAI 技術」の中での説明では、「薬局 誰か 受け取り」という検索キーワードがあった場合に、この場合の「誰か」が本人以外の誰かであることを理解できるようになったとしています。BERT導入以前は、この検索キーワードにおける「誰か」が重要な意味を持つということが理解できず、処方箋の受け取り方法に関する結果を主に返していたそうです。

次の記事で詳細にBERT導入前後の比較がされていますので引用しながら解説します。

Understanding searches better than ever before

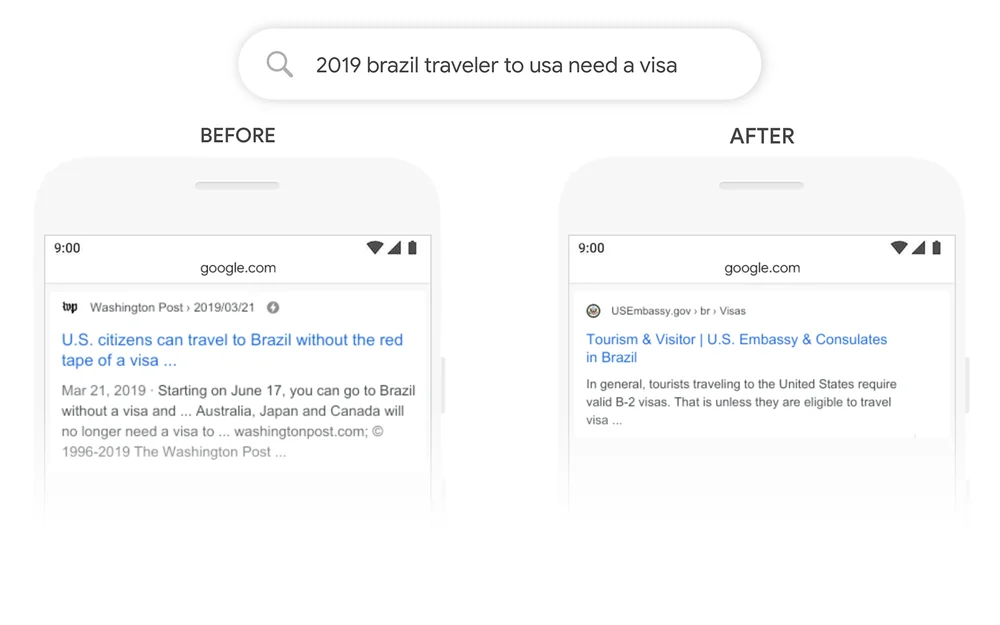

まず次の前後比較は「2019 brazil traveler to usa need a visa」という検索キーワードの例です。ブラジルから米国への旅行は2019年でビザが必要、という意味の文章ですが、これに対して以前は、米国からブラジルへの旅行に関する結果が示されてしまっていました。この文章においては「to」が強い意味を持ちますが、そのことを理解できてなかったのです。

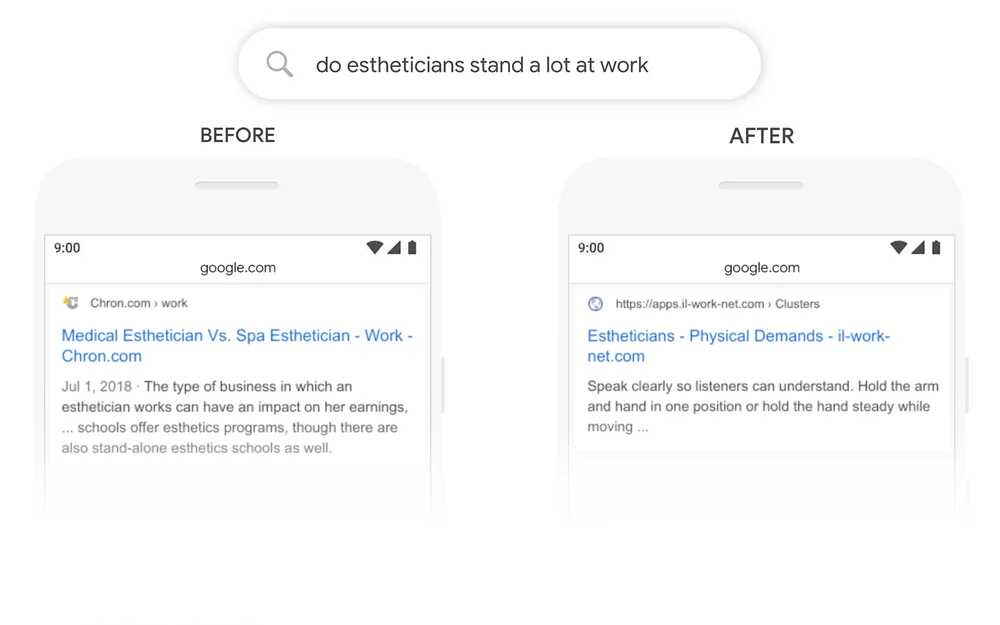

次の例は、「do estheticians stand a lot at work」という検索キーワードで、エステシャンは立ち仕事が多い、という意味です。

以前の結果は、stand-aloneという単語でヒットさせてしまっているのに対して、BERT導入後はエステシャンには肉体労働が求められるという主題の記事がヒットできており、以前より検索意図の理解度が高いことが分かります。

BERT導入によるSEOへの影響

かつてのSEO対策は、キーワード出現率が重要となっていました。そのページの中で「キーワード出現率が高いほどよい」、「キーワード出現率が3〜7%程度が良い」などという頃があったのです。なお、自然な文章においては、キーワード出現率は1〜3%程度となります。

実際に、SEO対策においてはキーワード出現率の高さに重きを置くしかなかったのが2000年以前です。2000年代に入ると、Googleは対策としてキーワード出現率が不自然に高い場合にペナルティを与えるようになりました。しかしこの対策は、あくまでもGoogleがキーワードで文章を把握していたということの表れであったと言えます。

当時はmetaタグのmeta keywordsというところにキーワードを書くことも必要でした。しかし2009年、Googleはmeta keywordsをランキングシステムの要素から除くことをしました。

2015年、GoogleはAIによる初の検索エンジンアルゴリズムであるRankBrainを導入し、文脈の理解ができるようになりました。そして2019年のBERTにより、その理解度は飛躍的に向上し、キーワードレベルでSEO対策を考える必要性はなくなったといえます。

そういった小手先のテクニックではなく、現在のSEO対策においては、コーディングの品質と、コンテンツのユーザーにとっての価値に集中すればよい、という状況になりました。健全なSEO対策の時代が幕を開けているといえます。

結果、現在はとにかくコンテンツです。自然な被リンクは現在もSEOの効果がありますが、だからと言ってそこに集中しても、そういった類のものは水物と言えます。Googleが被リンクを評価しなくなれば評価されなくなるわけです。ユーザーにとって価値の高いコンテンツが評価されるべきという評価軸は普遍的であると言えますし、コンテンツはずっと残り続けますので、コンテンツSEOは長い目で見た時の費用対効果も高く、おすすめのウェブマーケティング手法です。

BERT導入後に評価されているコンテンツとは?

BERTは検索意図を理解する能力が高いです。その検索キーワードで調べごとをしているユーザーが知りたいことが何かについて、顕在的なものと潜在的なものの両方を含めて把握しています。

潜在的な検索意図に関しては、Googleだからこそ分析できます。なぜなら、事前にはニーズとして顕在化してなかったとしても、検索してページを読んでいるうちに、気になってまたそのことを調べ出すといった行動をGoogleは把握できるからです。そういったユーザー行動とセットで検索キーワードをGoogleは分析しています。

そのため、検索意図を網羅的に満たすコンテンツが評価されやすいです。検索意図から逸れた内容が含まれると、評価は下がります。

また、BERTとは直接関係ありませんが、現在においてはオリジナリティが重要視されているということもお伝えしておきます。オリジナリティが重視される理由は、検索結果の多様性がユーザーにとっても価値があるからです。特に、一般的なことを教えてくれる生成AIの発展により、検索結果における多様性の意義は増していると言えます。

まとめ

GoogleのBERTは、検索エンジンの自然言語理解力を飛躍的に高め、パラダムシフトを起こしました。そして今は、ChatGPTも登場し、GoogleとChatGPTの組み合わせによってさまざまな情報に短時間のうちにアクセスできる良い時代になりました。

現在のSEO対策はある意味、頑張ったものは報われる仕組みになっています。ユーザーにとって価値の高い情報を多く発信すれば評価が高まります。とはいえ、どういうテーマで記事を書けば良いのかといったことや、カテゴリーの設け方など、やはりSEO対策は専門家出ないと難しい側面もあります。BringFlowerはその支援も行っていますので、よろしければご相談ください。